本周总结

主要工作总结

- Go1 步态复现

- 学习逆运动学并编写代码

2023.08.01

测试文件管理 (续)

方案一

任务导向

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

| > Logs

> A1_flat

> ANYmal_flat

> Go1_rough

> Go1_flat

> Year-Month-Date_Obs(48)_with-base-vel_

> checkpoints

- model_*.pt

> videos

- *.mp4

> policy

- policy.pt

> tensorboard

- events.out.tfevents.*

> training config

> Year-Month-Date_Obs(45)_non-base-vel_

> Good results (temp)

|

方案二

更新频率慢的 config 单独成文件夹

- observation num

- domain randomization

- heading command

- Kp, Kd

- …

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

| - Logs

- A1_flat

- ANYmal_flat

- Go1_rough

- Go1_flat

- dr

- dr(F)

README.md

parent_config.py

- Year-Month-Date_fat(2)

- checkpoints

- videos

- tensorboard

- policy

child_config.py

training_setting.md

- Year-Month-Date_fat(5)

- headingcommand(F)

- Good results (temp)

|

树结构

假设 Go1_flat 文件夹下进行了 2000 次测试,最后每个文件夹内包含 20 ~ 30 次测试

设三级文件夹目录:A(10) - B(10) - C(20/30)

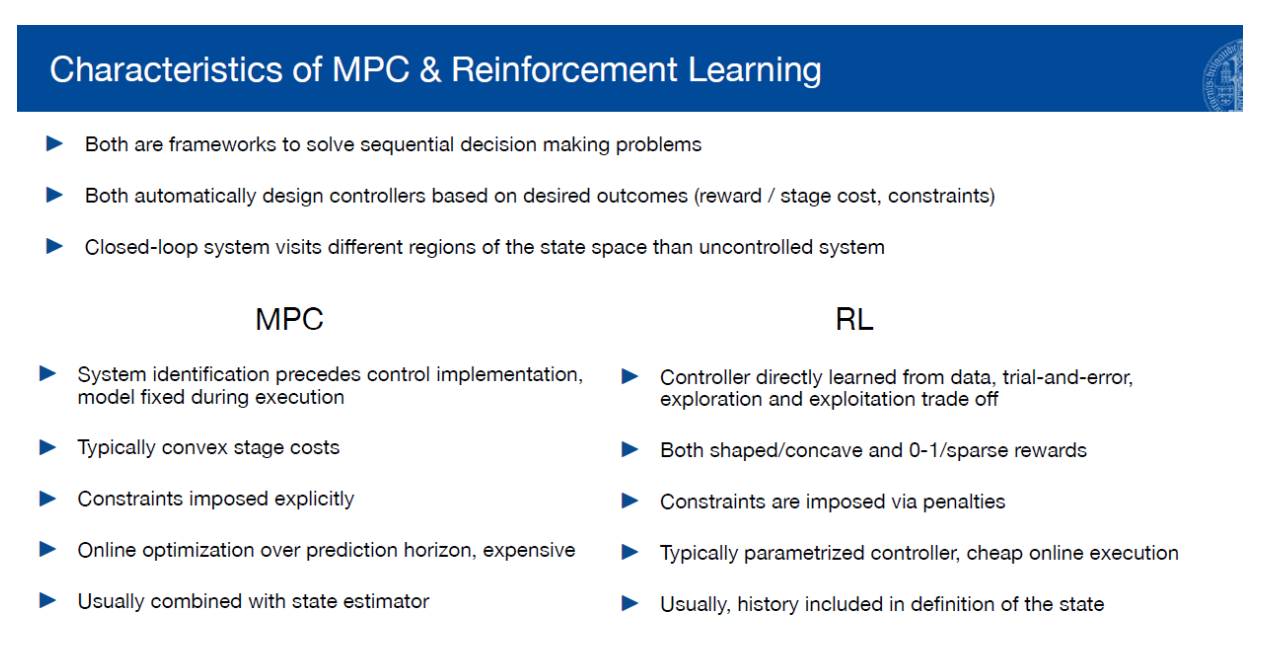

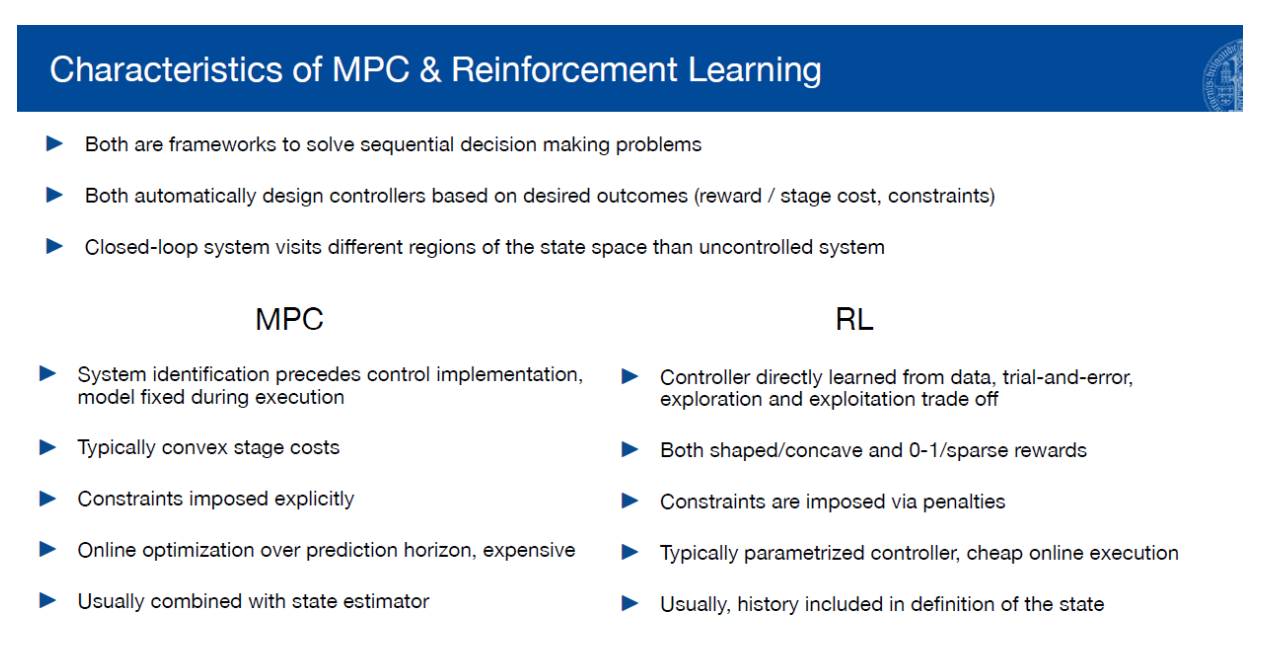

Model Predictive Control

一个模型预测控制(MPC)的简单实现 - 知乎

模型预测控制简介(model predictive control) - 知乎

模型预测控制 - 知乎

Reward Functions and Scales

Reward functions 的分类 / 重要性 / 特性

Reward function 与 Scales 的调整思路

分类

任务导向 / 姿态 / 自然 / 稳定性 / 敏捷性

对称性

一切从零开始

- 按照重要性分阶段添加 Reward functions

- 每一阶段逐步增加 Scale,观察效果 (指标?)

- 按照需求增加功能对立的 Reward functions

- Scale 从小到大变化,看是否得到更好的结果

2023.08.01

2023.08.03

正逆运动学

机器人的运动学解——逆向运动学解 | 知乎

干货 | “逆运动学”——从操作空间到关节空间 (上篇) | 知乎

干货 | “逆运动学”——从操作空间到关节空间 (下篇) | 知乎

以上三篇简明易懂,值得一读

Inverse Kinematics

机器人(机械臂)轨迹规划中,运动到奇异点,关节速度过大怎么解决? | 知乎

三维空间中的几何变换-平移旋转缩放 | swety_gxy 的博客

三维空间中的几何变换 (旋转矩阵、变换矩阵、旋转向量、欧拉角、四元数) | CV 科研随想录 的博客

2023.08.04

写 Isaac Gym 文档

- skrl (1.0.0-rc.1)

2023.08.05

逆运动学

写正逆运动学代码

Pytorch

- Tensors — PyTorch Tutorials 2.0.1+cu117 documentation

- 浅谈 PyTorch 中的 tensor 及使用 pytorch tensor | Adenialzz 的博客

- Pytorch 基础 Tensor 数据类型与常用函数

- Pytorch 基础 tensor 数据结构

- torch.matmul() 函数的文档详解 | Lowell_liu

- torch.unsqueeze() 方法 | 想变厉害的大白菜的博客

- torch.where() 用法 | euqlll 的博客

Inverse-Kinematic-Analysis-Of-A-Quadruped-Robot.pdf